Com’è questo Gpt 5: ecco i primi giudizi degli esperti internazionali

Il nuovo modello Gpt 5 è l’orizzonte di maturità per l’intelligenza artificiale. Un’evoluzione qualitativa, più che quantitativa, che consolida i progressi fatti finora e li rende più fruibili. Più efficaci, a 360 gradi. Così, Gp5 sposta ancora il baricentro dell’AI generativa. Sembra questo il primo giudizio concorde della stampa internazionale specializzata all’arrivo di Gpt 5 che – ricordiamo – è già disponibile anche in Italia, anche gratis in Chatgpt.

Chissà se davvero – come dice il capo di OpenAI Sam Altman – è un passo avanti verso l’intelligenza artificiale generale. Più probabilmente agli esperti appare come una transizione verso una “intelligenza operativa”. La stampa specializzata è colpita dai tanti miglioramenti pratici e misurabili. Gpt 5 mostra un ragionamento più robusto in catene di task, capacità di eseguire operazioni che prima richiedevano più orchestrazione umana, e prestazioni di coding che sono stato dell’arte, come nota l’americana Tom’s Guide.

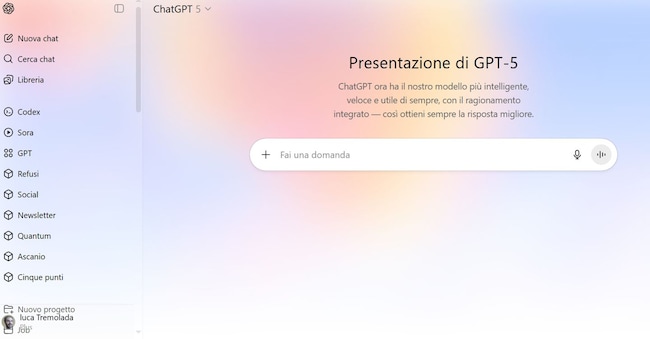

Interfaccia

Molti sono colpiti dalla pulizia dell’interfaccia in Chatgpt che ora non ti chiede più il modello e sceglie in autonomia se ragionare. Un progresso che dimostra un aumento di capacità decisionali autonome ma anche di efficienza energetica e computazionale, nota il Mit Technology Review. Efficienza dimostrata anche dalla scelta di rendere Gpt 5 gratis per tutti in Chatgpt. Certo gli utenti possono ancora con un clic forzare il “pensa più a lungo” e altri strumenti; e se Chatgpt si mette a ragionare possono invece forzare una risposta immediata.

Positivi i primi giudizi sulla qualità del ragionamento applicato a problemi reali. Secondo i tester e i commentatori tecnici (Tom’s Hardware, Techtarget), GPT 5 mostra una migliore “consistenza” nell’affrontare problemi multi-passo e una maggiore propensione a completare sequenze di operazioni senza “perdere” il filo. Progresso che incide sulla modalità d’uso. Ora il modello non si limita più a rispondere, ma governa flussi di lavoro che integrano ricerca, manipolazione dati e output finale. Il resoconto dei primi tester nei siti di riferimento sembra confermare che i progressi non sono causale ed estemporanei; sono proprio il frutto di interventi di tuning di OpenAI mirati proprio a questi scenari pratici. Teniamo conto che OpenAI si è presa due anni di lavoro per passare dai modelli 4 al 5.

A proposito di progressi pratici, l’azienda dice anche che le allucinazioni sono diminuite del 26 per cento e ora c’è il 44 per cento di possibilità in meno che una risposta contenga un errore fattuale importante. Su questo c’è per ora solo la voce dell’azienda, ma gli esperti già dicono che anche se fosse così non sarebbe comunque ottimale: significa che una risposta su dieci può ancora contenere allucinazioni, nota Mashable, ed è gravissimo con un uso che diventa sempre più comune: chiedere responsi medici a Chatgpt.

OpenAI ha testato Gpt 5 sul proprio benchmark interno, Simple QA. Questo test è una raccolta di “domande di ricerca di fatti con risposte brevi che misura l’accuratezza del modello per le risposte tentate”, secondo la descrizione della scheda del sistema. Per questa valutazione, GPT-5 non aveva accesso al web e le allucinazioni sono quindi altissimi: 47 per cento (40 per cento con il ragionamento), contro il 52 per cento del 4o.

Beth Barnes, fondatrice dell’organizzazione no profit di ricerca sull’intelligenza artificiale Metr, ha subito individuato un’inesattezza in una risposta di GPT-5 che spiega il funzionamento degli aerei.

Molti poi citano il progresso nel coding come uno dei traguardi più importanti in Gpt 5, colmando così le distanze con Claude Sonnet di Anthropic (ora lo strumento AI più diffuso per programmare). I dati condivisi da OpenAI e rilanciati dalle testate tecniche mostrano che il modello ottiene punteggi più alti in benchmark software-oriented (SWE-Bench e analoghi); impiega meno token e meno chiamate a strumenti esterni per risolvere lo stesso problema. Lo scarto qui è duplice: non solo il modello è più accurato nel produrre codice utile, ma lo è in modo più efficiente, elemento che riduce costi d’uso su scala e aumenta l’appetibilità per prodotti commerciali che puntano all’automazione di parte del ciclo di sviluppo. Serviranno certo test approfonditi per capire la qualità reale rispetto ai concorrenti, a livello pratico e di integrazione con i sistemi terzi.

Meno centrali nel dibattito, ma non poco importanti, altre due questioni: la finestra contestuale e la multimodalità. Le analisi tecniche riportano che Gpt 5 è stato progettato per gestire contesti molto più ampi — i numeri variano a seconda delle fonti e della configurazione, ma la direzione è chiara: lavorare con documenti lunghi, progetti multiparte, o conversazioni con memoria estesa diventa praticabile senza dover continuamente ricapitolare informazioni. Questa capacità è stata letta da molti esperti (Tom’s Hardware, PanelsAI) come un fattore abilitante per applicazioni professionali: revisioni contrattuali, reportistica continua, analisi finanziarie che richiedono coerenza su centinaia di pagine possono ora essere pilotate con meno intervento umano. Allo stesso tempo, le fonti tecniche rimarcano che la parola “multimodale” va intesa in modo pragmatico: miglior integrazione di testo, immagini e dati strutturati è già presente; audio e video sono prospettive di lavoro, ma la robustezza pratica dipende da casi d’uso e pipeline di integrazione.

Un altro filo ricorrente nelle pagine specializzate riguarda le “capability” agentiche e gli strumenti pensati per costruirle. La stampa tecnica (Techcrunch, Digital Watch Observatory) ha dedicato approfondimenti alle novità infrastrutturali che accompagnano il modello: Responses API, Agents SDK e sistemi di routing che permettono al modello di decidere se usare una modalità “thinking” o una risposta rapida sono tutti elementi che trasformano Gpt 5 in una piattaforma per agenti su misura piuttosto che in un semplice endpoint per completamenti testuali. Gli esperti spiegano che, grazie a queste api e sdk, sviluppatori e aziende possono orchestrare stack — ricerca sul web, chiamate a database interni, generazione di artefatti (slide, spreadsheet, codice) — con controlli di sicurezza e backup. Si riduce così la distanza fra prototipo e prodotto in produzione.

Accanto ai toni positivi, però, la stampa tecnica mantiene un registro critico e misurato: autorevoli blog e analisti chiedono verifiche indipendenti e benchmark riproducibili prima di trattare il rilascio come “svolta” definitiva. Platformer, Hacker News e altri commentatori del settore ricordano che le metriche esibite in briefing o in comunicati possono essere condizionate da set di test scelti a priori e da condizioni di tuning che non si replicano automaticamente in tutti gli ambienti di produzione. La comunità open e i forum tecnici — dove emergono test estemporanei e confronti dal basso — notano inoltre che la percezione di utilità può variare radicalmente a seconda del dominio: ciò che funziona bene per la scrittura di codice non è automaticamente trasferibile a compiti di valutazione clinica o a processi regolamentati. Questa richiesta di misurazione indipendente è un refrain ricorrente nella stampa tecnica.

Il tema costi e accesso è un altro elemento critico. Più articoli (come Platformer, The Verge) evidenziano come OpenAI abbia scelto una strategia a più livelli: modelli “mini” e “nano” per casi a basso costo e latenza, una versione “standard” per compiti pesanti e un’integrazione diretta in Chatgpt. Le testate di settore hanno osservato che questa mossa allargherà la base d’uso. Allo stesso tempo, i tecnici ricordano che il vero parametro economico da monitorare rimane il prezzo per token nelle pipeline di produzione: l’efficienza di Gpt 5 nel generare risposte con meno token e minori tool-call può tradursi in un vantaggio competitivo, ma la matematica dei costi dipende strettamente dal tipo di carico e dai pattern d’uso. Prudenza, quindi.

Ma soprattutto sul fronte della sicurezza e della governance, la stampa specializzata mostra attenzione e prudenza: la capacità estesa del modello di generare artefatti complessi e di orchestrare azioni su risorse esterne richiede nuovi strumenti di audit, limiti d’accesso e policy operative. Gli esperti tecnici ricordano che il problema non è solo la riduzione delle allucinazioni, ma la gestione delle dipendenze tra modello e sistemi aziendali — come si verifica una risposta, chi è responsabile dell’output e come si traccia la catena delle decisioni in presenza di agenti autonomi. Le discussioni tecniche mettono al centro questioni pratiche: logging, test in ambienti isolati, approvazioni umane obbligatorie su output sensibili e criteri chiari per bloccare funzionalità rischiose.

Tutto questo risuona molto familiare a noi europei, dato che il 2 agosto sono scattati gli obblighi AI Act per i fornitori di modelli a uso generale (come Gpt 5), con ricadute anche per le aziende che li utilizzano.

Notizie e approfondimenti sugli avvenimenti politici, economici e finanziari.

Iscrivitiilsole24ore