Meta-Plattformen zeigten Hunderte von „Nudify“-Deepfake-Anzeigen, stellt CBS News fest

Meta hat eine Reihe von Anzeigen für „Nudify“-Apps entfernt – KI- Tools, mit denen sexuell explizite Deepfakes unter Verwendung von Bildern echter Personen erstellt werden –, nachdem eine Untersuchung von CBS News Hunderte solcher Anzeigen auf seinen Plattformen gefunden hatte.

„Wir haben strenge Regeln gegen nicht einvernehmliche intime Bilder; wir haben diese Anzeigen entfernt, die für ihre Ausführung verantwortlichen Seiten gelöscht und die mit diesen Apps verbundenen URLs dauerhaft blockiert“, sagte ein Sprecher von Meta in einer per E-Mail versandten Erklärung gegenüber CBS News.

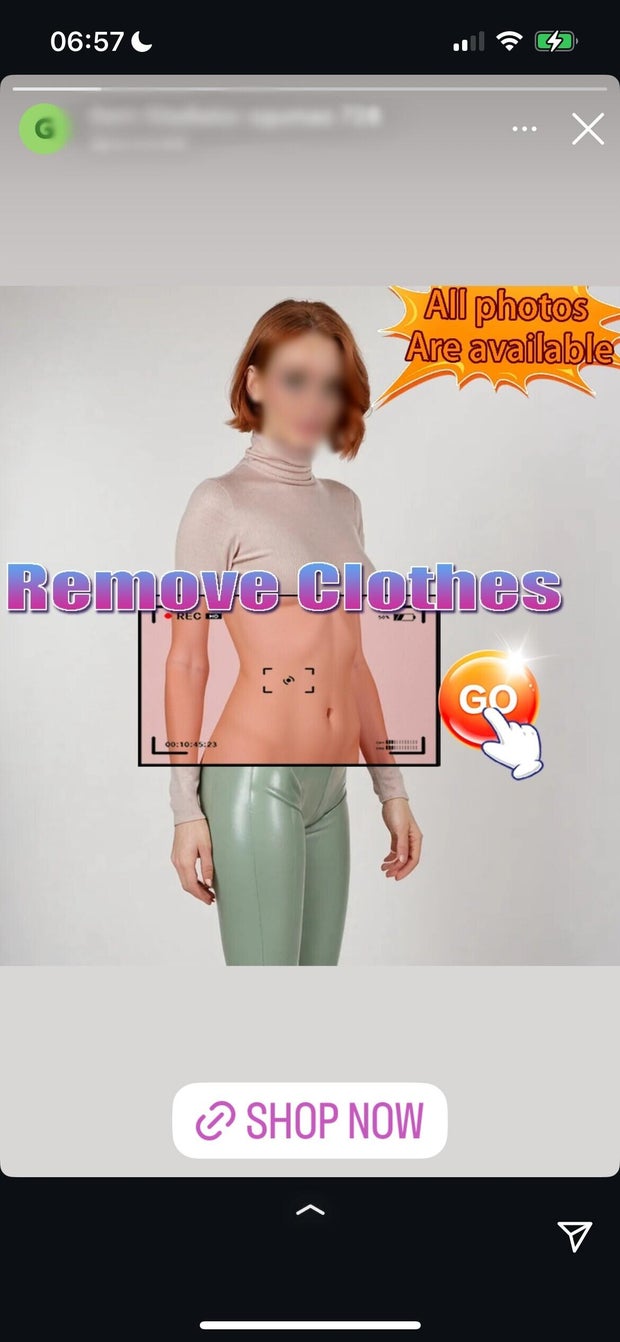

CBS News entdeckte Dutzende solcher Anzeigen auf Metas Instagram-Plattform in der Rubrik „Stories“. Sie warben für KI-Tools, die oft die Möglichkeit ankündigten, „ein Foto hochzuladen“ und „jemanden nackt zu sehen“. Andere Anzeigen in Instagrams Stories warben für das Hochladen und Bearbeiten von Videos von echten Menschen. In einer Werbeanzeige stand sogar unter einem Beispiel eines Nackt-Deepfakes der Text „Wie ist dieser Filter überhaupt erlaubt?“.

Eine Anzeige bewarb ihr KI-Produkt mit stark sexualisierten Deepfake-Bildern der Schauspielerinnen Scarlett Johansson und Anne Hathaway in Unterwäsche. Die URL-Links einiger Anzeigen verweisen auf Websites, die die Möglichkeit anpreisen, Bilder realer Personen zu animieren und sie zu sexuellen Handlungen zu bewegen. Für den Zugriff auf diese „exklusiven“ und „erweiterten“ Funktionen verlangten einige Anwendungen zwischen 20 und 80 US-Dollar. In anderen Fällen leitete die URL einer Anzeige Nutzer zum App Store von Apple weiter, wo „Nudify“-Apps zum Download bereitstanden.

Eine Analyse der Anzeigen in Metas Anzeigenbibliothek ergab, dass mindestens Hunderte dieser Anzeigen auf den Social-Media-Plattformen des Unternehmens verfügbar waren, darunter auf Facebook, Instagram, Threads, der Facebook Messenger-Anwendung und dem Meta Audience Network – einer Plattform, die es Meta-Werbetreibenden ermöglicht, Benutzer auf mobilen Apps und Websites zu erreichen, die mit dem Unternehmen zusammenarbeiten.

Laut den Daten der Anzeigenbibliothek von Meta waren viele dieser Anzeigen speziell auf Männer im Alter zwischen 18 und 65 Jahren ausgerichtet und waren in den Vereinigten Staaten, der Europäischen Union und dem Vereinigten Königreich aktiv.

Ein Sprecher von Meta erklärte gegenüber CBS News, dass die Verbreitung dieser Art von KI-generierten Inhalten ein anhaltendes Problem sei und dass man bei dem Versuch, es zu bekämpfen, vor immer anspruchsvolleren Herausforderungen stehe.

„Die Leute hinter diesen ausbeuterischen Apps entwickeln ihre Taktiken ständig weiter, um der Entdeckung zu entgehen. Deshalb arbeiten wir kontinuierlich daran, unsere Durchsetzung zu verstärken“, sagte ein Sprecher von Meta.

CBS News stellte fest, dass auf der Instagram-Plattform des Unternehmens weiterhin Anzeigen für „Nudify“-Deepfake-Tools verfügbar waren, selbst nachdem Meta die ursprünglich markierten Anzeigen entfernt hatte.

Deepfakes sind manipulierte Bilder, Audioaufnahmen oder Videos von echten Menschen, die mithilfe künstlicher Intelligenz verändert wurden, um fälschlicherweise darzustellen, dass jemand etwas gesagt oder getan hat, was die Person in Wirklichkeit nicht gesagt oder getan hat.

Letzten Monat unterzeichnete Präsident Trump den überparteilichen „ Take It Down Act “, der unter anderem Websites und Social-Media-Unternehmen dazu verpflichtet, Deepfake-Inhalte innerhalb von 48 Stunden nach Benachrichtigung durch ein Opfer zu entfernen.

Obwohl das Gesetz die „wissentliche Veröffentlichung“ oder die Androhung der Veröffentlichung intimer Bilder ohne die Zustimmung einer Person, einschließlich KI-generierter Deepfakes, unter Strafe stellt, zielt es nicht auf die Tools ab, die zur Erstellung solcher KI-generierter Inhalte verwendet werden.

Diese Tools verstoßen gegen die Sicherheits- und Moderationsregeln, die sowohl von Apple als auch von Meta auf ihren jeweiligen Plattformen implementiert wurden.

In den Werberichtlinien von Meta heißt es: „Anzeigen dürfen keine Nacktheit und sexuelle Handlungen von Erwachsenen enthalten. Dazu gehören Nacktheit, Darstellungen von Personen in expliziten oder sexuell anzüglichen Positionen oder Aktivitäten, die sexuell anzüglich sind.“

Metas Richtlinie gegen Mobbing und Belästigung verbietet zudem „abwertend sexualisierte Photoshop- oder Zeichnungsdateien“ auf seinen Plattformen. Das Unternehmen gibt an, dass seine Regelungen Nutzer daran hindern sollen, intime Bilder ohne deren Zustimmung zu teilen oder mit deren Weitergabe zu drohen.

In den Richtlinien von Apple für seinen App Store heißt es ausdrücklich, dass „Inhalte, die beleidigend, unsensibel, verstörend, abstoßend, außergewöhnlich geschmacklos oder einfach nur gruselig sind“, verboten sind.

Alexios Mantzarlis, Direktor der Security, Trust and Safety Initiative am Technologieforschungszentrum der Cornell University, untersucht seit über einem Jahr den Anstieg von KI-Deepfake-Netzwerk-Marketing auf sozialen Plattformen. In einem Telefoninterview mit CBS News am Dienstag sagte er, er habe in diesem Zeitraum Tausende solcher Anzeigen auf Meta-Plattformen sowie auf Plattformen wie X und Telegram gesehen.

Obwohl bei Telegram und X eine strukturelle „Gesetzlosigkeit“ herrscht, die diese Art von Inhalten ermöglicht, glaubt er, dass der Führung von Meta der Wille fehlt, das Problem anzugehen, obwohl es Inhaltsmoderatoren gibt.

„Ich glaube, dass sich die Vertrauens- und Sicherheitsteams dieser Unternehmen darum kümmern. Ehrlich gesagt glaube ich nicht, dass sie sich im Fall von Meta an der Unternehmensspitze darum kümmern“, sagte er. „Sie stellen den Teams, die sich mit diesem Problem befassen müssen, eindeutig zu wenig Ressourcen zur Verfügung, denn so ausgefeilt diese [Deepfake-]Netzwerke auch sind … ihnen fehlt das Geld von Meta, um sie zu finanzieren.“

Mantzarlis sagte außerdem, er habe bei seinen Untersuchungen herausgefunden, dass „Nudify“-Deepfake-Generatoren sowohl im App Store von Apple als auch im Play Store von Google zum Download bereitstehen, und äußerte seine Frustration über die Unfähigkeit dieser riesigen Plattformen, solche Inhalte durchzusetzen.

„Das Problem mit Apps ist, dass sie eine Doppelfunktion haben: Sie präsentieren sich im App Store als unterhaltsame Möglichkeit, Gesichter auszutauschen, vermarkten sie auf Meta aber als ihren Hauptzweck, Nacktheit zu betreiben. Wenn diese Apps also im Apple- oder Google-Store zur Überprüfung anstehen, haben sie nicht unbedingt die Mittel, sie zu verbieten“, sagte er.

„Es muss eine branchenübergreifende Zusammenarbeit geben. Wenn die App oder Website sich irgendwo im Web als Tool zur Nacktheit vermarktet, können alle anderen sagen: ‚Okay, es ist mir egal, wie du dich auf meiner Plattform präsentierst, du bist weg‘“, fügte Mantzarlis hinzu.

CBS News hat Apple und Google um eine Stellungnahme zur Moderation ihrer jeweiligen Plattformen gebeten. Bis zum Redaktionsschluss lag noch keines der beiden Unternehmen vor.

Die Werbung großer Technologieunternehmen für solche Apps wirft ernsthafte Fragen sowohl hinsichtlich der Einwilligung der Nutzer als auch hinsichtlich der Online-Sicherheit für Minderjährige auf. Eine Analyse von CBS News einer auf Instagram beworbenen „Nudify“-Website ergab, dass die Website keinerlei Altersverifizierung vornahm, bevor ein Nutzer ein Foto hochlud, um ein Deepfake-Bild zu erstellen.

Solche Probleme sind weit verbreitet. Im Dezember berichtete die Sendung „60 Minutes“ von CBS News über die fehlende Altersverifizierung auf einer der beliebtesten Websites, die künstliche Intelligenz nutzt, um gefälschte Nacktfotos von echten Menschen zu erstellen.

Obwohl den Besuchern mitgeteilt wurde, dass sie mindestens 18 Jahre alt sein müssen, um die Site nutzen zu können und dass „die Verarbeitung von Daten Minderjähriger nicht möglich ist“, konnte 60 Minutes sofort auf das Hochladen von Fotos zugreifen, nachdem der Benutzer in der Alterswarnung auf „Akzeptieren“ geklickt hatte, ohne dass eine weitere Altersüberprüfung erforderlich war.

Daten zeigen auch, dass ein hoher Prozentsatz minderjähriger Teenager mit Deepfake-Inhalten interagiert hat. Eine im März 2025 von der gemeinnützigen Kinderschutzorganisation Thorn durchgeführte Studie ergab, dass 41 % der Jugendlichen angaben, den Begriff „Deepfake-Nacktbilder“ schon einmal gehört zu haben, während 10 % angaben, jemanden persönlich zu kennen, von dem Deepfake-Nacktbilder erstellt wurden.

Emmet Lyons ist Nachrichtenredakteur im Londoner Büro von CBS News und koordiniert und produziert Beiträge für alle CBS-News-Plattformen. Vor seinem Wechsel zu CBS News arbeitete Emmet vier Jahre lang als Produzent bei CNN.

Cbs News