Accessibilité numérique, Apple présente de nouvelles fonctionnalités pour 2025

Le 15 mai est la Journée mondiale de sensibilisation à l’accessibilité, une journée internationale célébrée chaque année ce mois-ci pour sensibiliser à la question de l’accessibilité numérique. Apple a lancé la division qui s'occupe du développement de ces solutions il y a 40 ans. Un chemin qui a suivi l’évolution des technologies et des appareils : l’arrivée de la voix off sur l’iPhone en 2009, les « aides auditives MFi ». « Aides auditives Made for iPhone » — c'est-à-dire des aides auditives compatibles avec l'iPhone en 2014, un mode « lecteur d'accessibilité » pour faciliter la lecture aux utilisateurs souffrant de handicaps visuels ou cognitifs l'année dernière, etc.

Pour 2025, il a introduit une série de nouvelles fonctionnalités, à venir plus tard cette année, à commencer par les cartes d'accessibilité sur l'App Store, puis Lens pour Mac, Braille Access and Accessibility Reader, et plus encore. Tout au long du mois de mai, certains magasins Apple disposeront de tables dédiées mettant en évidence les fonctionnalités d'accessibilité sur divers appareils. En plus des sessions Today at Apple dédiées à ce sujet tout au long de l'année.

« L’accessibilité fait partie de l’ADN d’Apple », a déclaré Tim Cook, PDG d’Apple. Créer une technologie accessible à tous est une priorité pour nous, et nous sommes ravis des innovations que nous proposons cette année. Nous proposerons des outils pour aider chacun à accéder à des informations essentielles, à explorer le monde qui l'entoure et à faire tout ce qu'il aime.

« Chez Apple, nous avons 40 ans d'expérience en matière d'innovation en matière d'accessibilité et nous nous engageons à continuer de repousser les limites en introduisant de nouvelles fonctionnalités d'accessibilité dans tous nos produits », a déclaré Sarah Herrlinger, directrice principale de la politique et des initiatives d'accessibilité mondiales d'Apple. « Tirant parti de la puissance de l'écosystème Apple, ces fonctionnalités fonctionnent ensemble de manière transparente pour offrir aux utilisateurs de nouvelles façons d'interagir avec les choses qui leur tiennent le plus à cœur. »

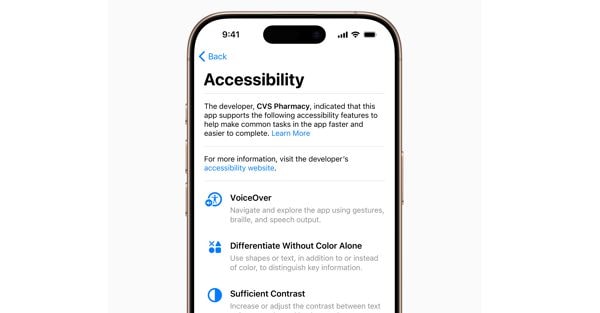

Les cartes d'accessibilité introduisent une nouvelle section sur les pages produits de l'App Store qui mettra en évidence les fonctionnalités d'accessibilité dans les applications et les jeux. Ces cartes offriront aux utilisateurs une nouvelle façon de savoir si une application est accessible avant de la télécharger, donnant ainsi aux développeurs la possibilité de mieux informer et expliquer aux utilisateurs quelles fonctionnalités leur application prend en charge. Il s'agit notamment de VoiceOver, du contrôle vocal, d'un texte plus grand, d'un bon contraste, de la réduction des mouvements, des transcriptions, etc.

Cartes d'accessibilité pour les applications

Depuis 2016, l'application Loupe sur iPhone et iPad offre aux personnes aveugles ou malvoyantes des outils pour agrandir, lire du texte et détecter les objets qui les entourent. Cette année, l’application Lens arrive sur Mac pour rendre le monde réel plus accessible aux personnes malvoyantes. L'application Lens pour Mac se connecte à votre appareil photo, vous permettant d'agrandir tout ce qui vous entoure, comme un écran ou un tableau blanc. Lens fonctionne avec la caméra Continuity sur iPhone et les caméras USB connectées, et prend en charge la lecture de documents à l'aide de Desktop Overview.

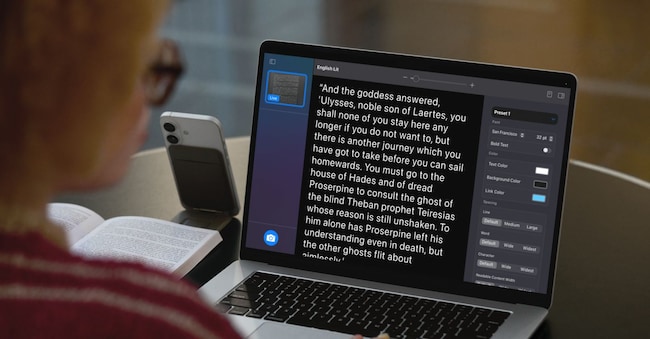

Avec plusieurs fenêtres de session en direct, les utilisateurs peuvent effectuer plusieurs tâches à la fois en visualisant une présentation avec une webcam tout en suivant simultanément un livre avec Desktop Overview. Grâce à des vues personnalisées, ils peuvent ajuster la luminosité, le contraste, les filtres de couleur et même la perspective pour rendre le texte et les images plus faciles à lire. Ils pourront également capturer, regrouper et enregistrer des vues pour travailler dessus ultérieurement. De plus, l'application Lens pour Mac intègre une autre nouvelle fonctionnalité d'accessibilité, Accessibility Reader, qui transforme le texte détecté dans le monde réel en un format lisible personnalisé.

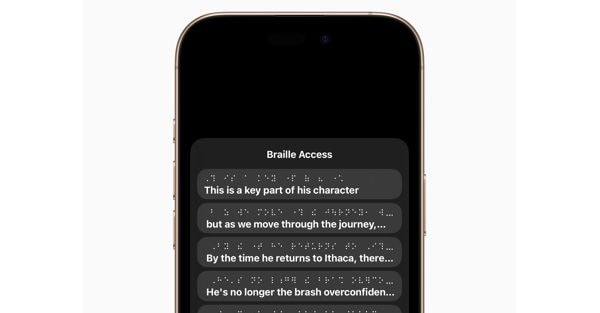

Lecture en braille

Braille Access transforme l'iPhone, l'iPad, le Mac et l'Apple Vision Pro en outils complets pour prendre des notes en braille, le système de lecture et d'écriture tactile principalement utilisé par les personnes aveugles ou malvoyantes. Grâce à un lanceur d'applications intégré, les utilisateurs peuvent facilement ouvrir n'importe quelle application en tapant avec « Saisie braille à l'écran » ou un appareil braille connecté. Avec Braille Access, vous pouvez prendre des notes à la volée en braille et effectuer des calculs à l'aide du code braille Nemeth, souvent utilisé dans les classes de sciences et de mathématiques. Les utilisateurs peuvent ouvrir les fichiers Braille Ready Format (BRF) directement depuis « Braille Access », déverrouillant ainsi une large gamme de livres et de fichiers précédemment créés sur des appareils prenant en charge la prise de notes en braille. Et grâce à une version intégrée de « Live Transcriptions », ils peuvent transcrire les conversations en temps réel directement sur des afficheurs Braille.

Accessibility Reader est un nouveau mode de lecture à l'échelle du système conçu pour faciliter la lecture de textes pour les utilisateurs souffrant de divers handicaps, tels que la dyslexie ou la basse vision. Disponible sur iPhone, iPad, Mac et Apple Vision Pro, Accessibility Reader offre aux utilisateurs de nouvelles façons de personnaliser le texte et de se concentrer sur le contenu qu'ils souhaitent lire, avec plusieurs options de police, de couleur et d'espacement, ainsi que la prise en charge de la « lecture du contenu à voix haute ». Accessibility Reader peut être lancé à partir de n'importe quelle application et est intégré à l'application Lens pour iOS, iPadOS et macOS, permettant aux utilisateurs d'interagir avec du texte réel, comme des livres ou des menus de restaurant.

Conçues pour les personnes sourdes ou malentendantes, les commandes Live Listen arrivent sur Apple Watch avec un nouvel ensemble de fonctionnalités, notamment des transcriptions en direct en temps réel. Live Listen transforme l'iPhone en microphone à distance pour diffuser du contenu directement sur des AirPods, des écouteurs Beats ou des aides auditives Made for iPhone. Lorsqu'une session est active sur l'iPhone, les utilisateurs peuvent afficher les « transcriptions en direct » du contenu détecté par l'iPhone sur une Apple Watch couplée tout en écoutant l'audio. L'Apple Watch agit comme une télécommande pour démarrer ou arrêter les sessions d'écoute en direct, ou pour revenir à une session pour rattraper tout ce que vous auriez pu manquer. Avec Apple Watch, les utilisateurs peuvent contrôler les sessions Live Listen depuis l’autre bout de la pièce, sans avoir à se lever au milieu d’une réunion ou d’une conférence.

Pour les personnes aveugles ou malvoyantes, visionOS étendra les fonctionnalités d’accessibilité visuelle à l’aide du système de caméra avancé d’Apple Vision Pro. Grâce aux puissantes mises à jour de Zoom, les utilisateurs pourront agrandir tout ce qui se trouve dans leur champ de vision, y compris leur environnement, à l'aide de la caméra principale. Pour ceux qui utilisent VoiceOver, la reconnaissance en temps réel dans visionOS utilise l'apprentissage automatique sur l'appareil pour décrire votre environnement, rechercher des objets, lire des documents, etc.

Actualités et éclairages sur les événements politiques, économiques et financiers.

S'inscrireilsole24ore